AMD presenta la nueva tarjeta de red Pollara 400GbE, diseñada para conexiones de inteligencia artificial y computación de alto rendimiento, con estándares abiertos y menor latencia en grandes clusters.

La Pollara 400 AI NIC ya está en proceso de envío, mientras que se espera que la Vulcano 800G AI esté disponible en 2026.

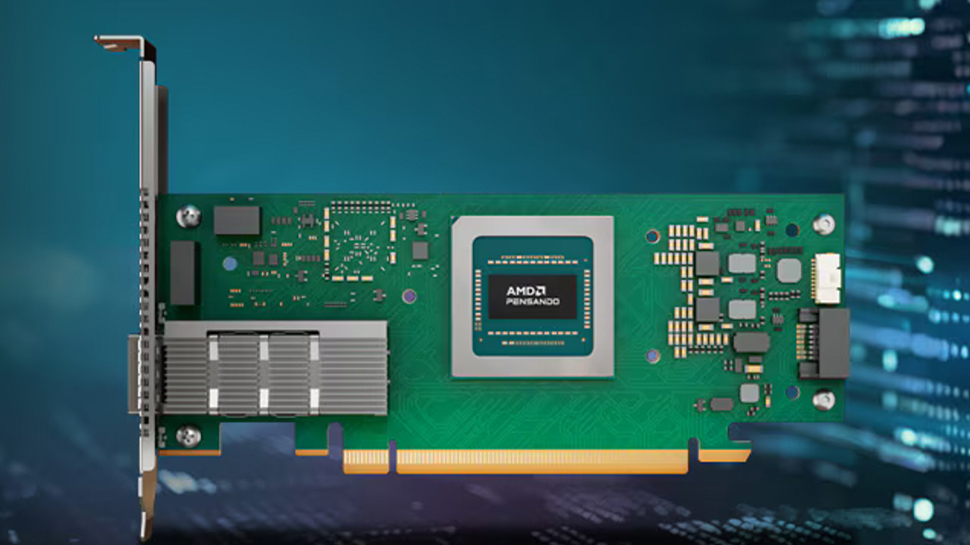

AMD ha comenzado a distribuir la tarjeta de red Pollara 400 AI, que forma parte de su iniciativa para ofrecer networking en centros de datos de alta velocidad y de código abierto. Esta tarjeta ha sido diseñada para sistemas PCIe Gen5 y cumple con el estándar del Ultra Ethernet Consortium (UEC), cuyo propósito es innovar la tecnología Ethernet para aplicaciones de inteligencia artificial (IA) y computación de alto rendimiento (HPC) a gran escala.

La Pollara 400 AI incluye soporte para RDMA y está optimizada para la comunicación colectiva horizontal mediante RCCL, que es la alternativa de AMD a NCCL. Comparando rendimientos, AMD afirma que esta tarjeta presenta un desempeño RDMA aproximadamente un 10% superior al de la ConnectX-7 de Nvidia y un 20% mejor que la Thor2 de Broadcom, lo que resulta en una disminución en los tiempos de inactividad y en una mejora de la eficiencia de las cargas de trabajo en clusters con abundancia de GPUs.

Equipado con un procesador personalizado, el NIC (tarjeta de interfaz de red) permite protocolos de transporte flexibles, balanceo de carga y enrutamiento de conmutación por error. Esto le otorga la capacidad de redirigir el tráfico en momentos de congestión y mantener la conectividad entre GPUs durante fallos. La tarjeta presenta un diseño de medio alto y medio largo, y soporta PCIe Gen5 x16, con configuraciones que incluyen 1x400G, 2x200G y 4x100G, logrando un ancho de banda de hasta 400 Gbps y herramientas de monitoreo que mejoran la observabilidad y confiabilidad a nivel de clúster.

AMD también menciona que en implementaciones a gran escala se pueden lograr aumentos de rendimiento de hasta 6 veces, especialmente cuando se escala a cientos de miles de procesadores. Para cargas de trabajo individuales, se reporta un rendimiento en trabajos de IA hasta un 15% más rápido y una mejora en la confiabilidad de la red de hasta el 10% gracias a características como la conmutación rápida por error, retransmisión selectiva y gestión de congestión.

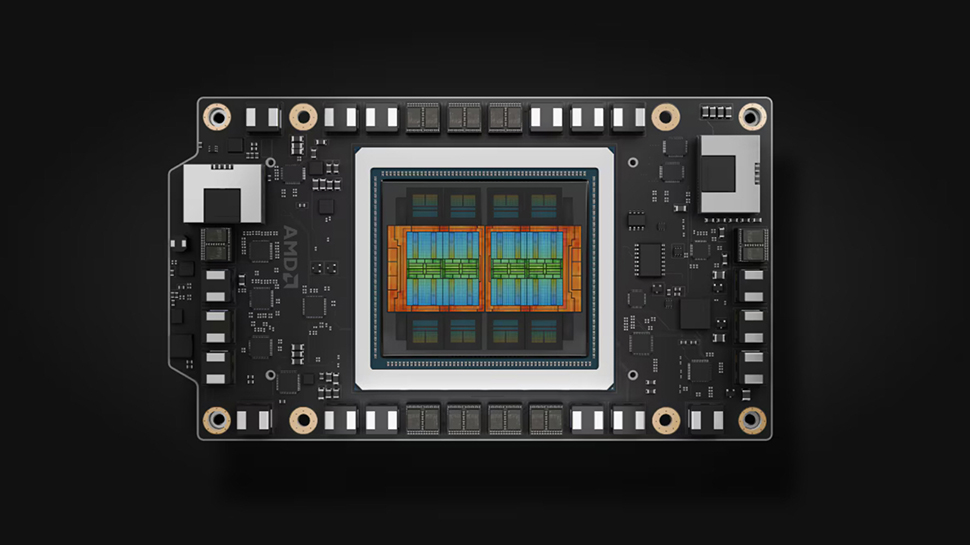

Con la finalización de la Especificación UEC 1.0, la compañía tiene la vista puesta en los hiperescaladores, siendo Oracle Cloud uno de los primeros en adoptar esta tecnología. De cara a 2026, AMD planea lanzar la tarjeta de red Vulcano 800G AI para sistemas PCIe Gen6. Esta nueva NIC soportará tanto Ultra Ethernet como UALink para facilitar el networking a gran escala en cargas de trabajo de IA extensas. Vulcano formará parte de la arquitectura rack-scale Helios de AMD, que está prevista para el mismo año.

AMD está posicionando Vulcano como una alternativa abierta y multi-vendor a la ConnectX-8 de Nvidia, siendo su éxito influenciado por la rapidez con la que el ecosistema adopte y apoye los nuevos estándares de networking.

Un análisis sobre estas dos tarjetas de red sugiere que para competir en clústeres de IA en 2026, no solo se necesitan chips de IA, sino también la capacidad de escalar tanto hacia arriba como hacia afuera. A pesar de que el enfoque de AMD suena similar al de Nvidia por la necesidad de contar con una NIC, su respaldo a estándares abiertos marca una diferencia fundamental en comparación con la estrategia de Nvidia.