AMD adopta una estrategia de GPU modular con el MI355X, poniendo fin a los diseños de APU tipo MI300A.

AMD asevera tener una ventaja en inferencia de entre 1.2 a 1.3 veces sobre las ofertas B200 y GB200 de Nvidia.

AMD ha presentado recientemente sus nuevas GPUs, MI350X y MI355X, para cargas de trabajo de inteligencia artificial en su evento de 2025, centrado en el avance de la IA. Ambas tarjetas están construidas sobre la arquitectura CDNA 4, aunque el modelo MI355X se destaca por ser la variante de alto rendimiento y refrigeración líquida, diseñada para implementaciones grandes y exigentes.

La MI355X permite la instalación de hasta 128 GPUs por rack y está optimizada para ofrecer un alto rendimiento en tareas tanto de entrenamiento como de inferencia, con una capacidad de memoria de 288GB HBM3E y un ancho de banda de 8TB/s. AMD asegura que esta GPU puede llegar a ofrecer hasta cuatro veces más potencia de cálculo para IA y 35 veces más rendimiento en inferencia en comparación con la generación anterior, todo gracias a mejoras arquitectónicas y el uso del proceso N3P de TSMC.

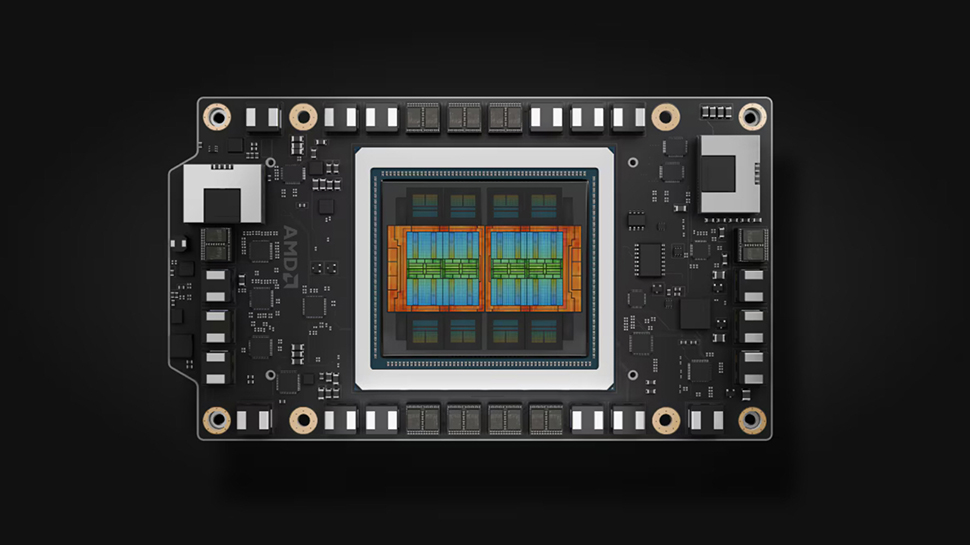

En su interior, el chip cuenta con ocho die de procesamiento, 256 unidades de cómputo activas y un total de 185 mil millones de transistores, lo que representa un incremento del 21% respecto al modelo previo. Cada die se conecta a través de nuevos módulos I/O, que se han reducido de cuatro a dos, lo que duplica el ancho de banda interno y reduce el consumo energético.

A diferencia de su predecesor MI300A, que combinaba CPU y GPU en un APU, la MI355X es solo GPU, lo que facilita su despliegue modular y flexibilidad de rack. Se conecta a los servidores a través de una interfaz PCIe 5.0 x16 y se comunica con otras GPUs a través de siete enlaces de Infinity Fabric, alcanzando más de 1TB/s de ancho de banda GPU a GPU.

La MI355X también incorpora memoria de caché Infinity de 32MB por cada pila HBM y es compatible con formatos de menor precisión como FP4 y FP6, lo que resulta beneficioso para cargas de trabajo centradas en la inferencia. AMD afirma que su capacidad de memoria HBM3E es 1.6 veces superior a la de los modelos B200 y GB200 de Nvidia, mientras que el rendimiento en inferencia supera a los principales productos de la competencia en un 1.2x a 1.3x.

Respecto al consumo energético, esta GPU puede llegar a consumir 1,400W en su versión refrigerada por líquido, lo que mejora la densidad de rendimiento por rack y optimiza el costo total de propiedad (TCO) al permitir escalabilidad de cómputo sin necesidad de ampliar el espacio físico. El chip está diseñado para encajar en módulos OAM estándar y es compatible con servidores de la plataforma UBB, lo que acelera su despliegue.

AMD también ha anunciado planes para lanzar su serie Instinct MI400 en 2026, reafirmando su compromiso con la innovación en el ámbito de la inteligencia artificial.