El nuevo modelo de Anthropic destaca en razonamiento y planificación, y demuestra sus habilidades con Pokémon.

Cuando el modelo anterior de Anthropic, Claude, jugó Pokemon Red, pasó "docenas de horas" atascado en una ciudad y tuvo dificultades para reconocer a los personajes no jugables. Con el lanzamiento de Claude 4 Opus, el equipo observó una mejora en la memoria a largo plazo y en las habilidades de planificación de Claude.

Durante su primera conferencia de desarrolladores en San Francisco, Anthropic presentó dos nuevos modelos: Claude 4 Opus y Claude Sonnet 4. Ambos estarán disponibles inmediatamente para los suscriptores de pago de Claude. Estos modelos, que saltan de la versión 3.7 a la 4, incorporan diversas capacidades mejoradas, como la razonabilidad, la planificación y la capacidad de recordar el contexto de las conversaciones durante períodos prolongados.

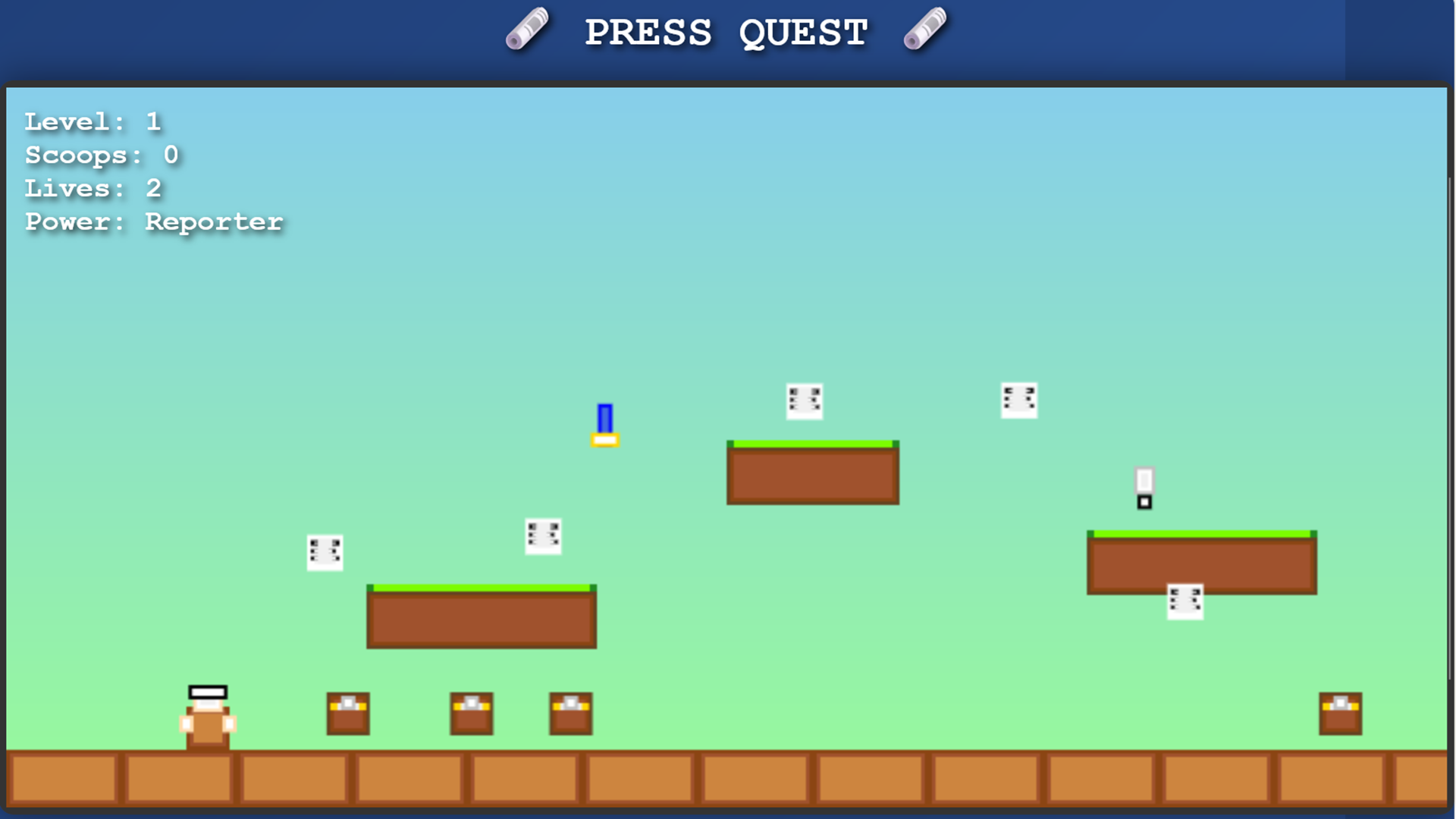

Claude 4 Opus ha demostrado un avance significativo en el juego de Pokémon, logrando jugar durante 24 horas continuas, a diferencia de los 45 minutos que podía jugar su predecesor, según Mike Krieger, el director de producto de la compañía. Un par de meses atrás, Anthropic lanzó una transmisión en Twitch titulada "Claude Plays Pokémon", en la cual se exhibían las habilidades de Claude 3.7 Sonnet en Pokémon Rojo, una demostración que tenía como objetivo mostrar cómo el modelo analiza el juego y toma decisiones de forma gradual con mínima orientación.

David Hershey, quien lidera la investigación sobre Pokémon en Anthropic, eligió Pokémon Rojo por su simplicidad. Este juego, basado en turnos, no requiere reacciones en tiempo real, lo que representa un desafío para los modelos actuales de la compañía. Hershey mencionó que el juego tiene un significado especial para él, ya que fue el primer videojuego que jugó en su Game Boy original en 1997. Su objetivo principal con esta investigación es entender cómo Claude puede actuar como un agente, realizando tareas complejas de forma independiente.

A pesar de que Claude 3.7 Sonnet se encontró con varios obstáculos durante el juego, como quedar atascado en una ciudad y dificultades para identificar personajes no jugables, Claude 4 Opus mostró mejoras en su memoria a largo plazo y habilidades de planificación. Hershey observó cómo el modelo identificaba la necesidad de una habilidad específica y pasó dos días mejorando sus destrezas antes de continuar jugando. Este tipo de razonamiento de múltiples pasos, sin retroalimentación inmediata, evidencia una mayor coherencia y capacidad para mantenerse enfocado en la tarea.

La investigación de Anthropic sobre Pokémon busca comprender mejor cómo un AI toma decisiones en tareas complejas y cómo se le puede direccionar en la dirección correcta. Esto es vital para el avance de pioneros AI agents que pueden abordar tareas complicadas de manera relativamente autónoma, manteniendo el contexto y evitando olvidar los objetivos a largo plazo.

Krieger manifestó que el objetivo principal de Anthropic para este año es que Claude pueda ejecutar horas de trabajo para los usuarios. Se citó el caso de un cliente que hizo uso del modelo para realizar un refactor completo durante siete horas. Anthropic, como otras empresas de AI, aspira a desarrollar agentes potentes que puedan ofrecerse como productos a los consumidores.

En comparación con sus competidores, Anthropic es reconocida por su enfoque más cauteloso, priorizando la investigación rápida pero con una implementación más lenta. El desarrollo de modelos de AI seguros es crucial, especialmente dado el acceso a información sensible de los usuarios. En un comunicado reciente, la compañía indicó que tanto Claude 4 Opus como Claude Sonnet 4 son un 65% menos propensos a comportamientos de atajos que los modelos anteriores, particularmente en tareas de codificación.

Jared Kaplan, científico principal de la compañía, mencionó que Claude 4 Opus es el primer modelo clasificado como ASL-3, un nivel de seguridad que evalúa los riesgos asociados. Esta clasificación implica un mayor incremento del riesgo de mal uso catastrófico en comparación con modelos no AI. Anthropic está comprometida en construir sistemas de inteligencia artificial que manejen tareas cada vez más complejas de forma segura y confiable, un desafío clave en el futuro de la tecnología AI.