Conoce al agente de IA con múltiples personalidades.

Un nuevo agente de inteligencia artificial desarrollado por la startup Simular alterna entre distintos modelos de IA según la tarea que se le asigne.

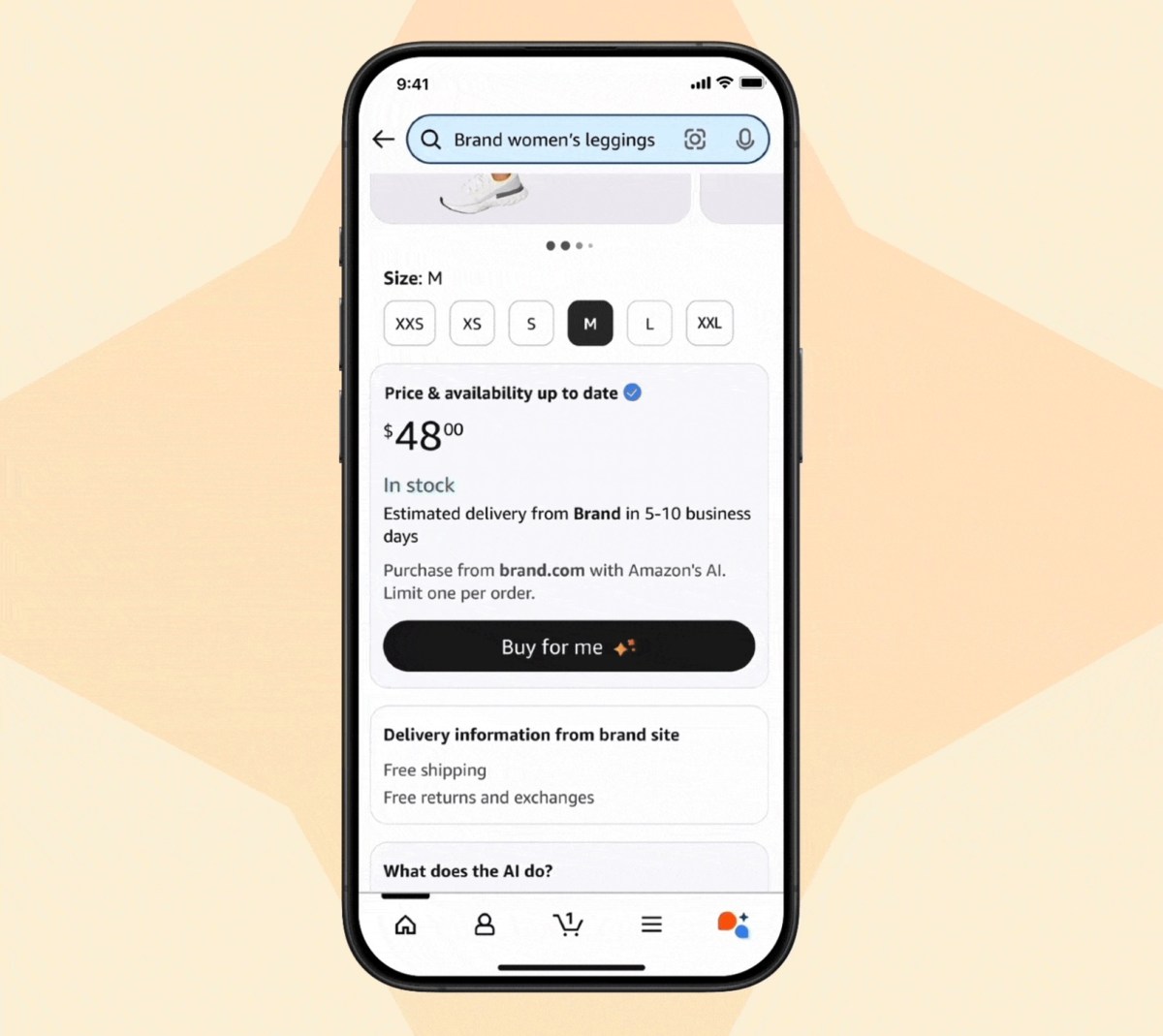

En los próximos años, se espera que los agentes asuman un número creciente de tareas en nombre de los humanos, incluyendo el uso de computadoras y teléfonos inteligentes. Sin embargo, por el momento, presentan demasiados errores para ser realmente útiles. Un nuevo agente denominado S2, desarrollado por la startup Simular AI, combina modelos avanzados con otros especializados en el uso de computadoras. Este agente ha demostrado un rendimiento sobresaliente en tareas como la utilización de aplicaciones y la manipulación de archivos, lo que sugiere que la elección de diferentes modelos en distintas situaciones puede ser clave para el avance de estos agentes.

Ang Li, cofundador y CEO de Simular, señala que los agentes que utilizan computadoras representan un desafío diferente a los grandes modelos de lenguaje. En el enfoque de Simular, un modelo de inteligencia artificial de propósito general, como GPT-4o de OpenAI o Claude 3.7 de Anthropic, se utiliza para razonar sobre la mejor forma de completar una tarea, mientras que modelos de código abierto más pequeños abordan tareas como la interpretación de páginas web. Li, quien anteriormente trabajó en Google DeepMind antes de fundar Simular en 2023, comenta que aunque los grandes modelos de lenguaje son excelentes en la planificación, no son tan efectivos al identificar elementos en una interfaz gráfica de usuario.

S2 está diseñado para aprender a partir de la experiencia, utilizando un módulo de memoria externa que registra acciones y retroalimentación del usuario, empleando esta información para mejorar en futuras ejecuciones. En tareas particularmente complejas, S2 supera a cualquier otro modelo en OSWorld, un estándar que mide la capacidad de un agente para usar un sistema operativo de computadora. Por ejemplo, S2 puede completar el 34.5 por ciento de las tareas que involucran 50 pasos, superando a OpenAI’s Operator, que logra el 32 por ciento. Asimismo, en AndroidWorld, una referencia para agentes que utilizan teléfonos inteligentes, S2 alcanza un 50 por ciento, mientras que el siguiente mejor agente se queda en un 46 por ciento.

Victor Zhong, un científico de la computación en la Universidad de Waterloo, cree que futuros modelos de inteligencia artificial de gran envergadura podrían integrar datos de entrenamiento que les ayuden a comprender el mundo visual y a interactuar con interfaces gráficas de usuario. Zhong considera que esto permitirá que los agentes naveguen en estas interfaces con mayor precisión. Mientras tanto, los sistemas más avanzados seguirán un enfoque similar al de Simular, combinando múltiples modelos para superar las limitaciones de los individuales.

En una prueba personal, utilicé Simular para reservar vuelos y buscar ofertas en Amazon, notando que su desempeño era superior al de algunos agentes de código abierto que había probado el año anterior, como AutoGen y vimGPT. No obstante, incluso los agentes de inteligencia artificial más sofisticados siguen enfrentándose a problemas con casos particulares y, en ocasiones, muestran comportamientos extraños. Por ejemplo, cuando solicité a S2 que me ayudara a encontrar información de contacto de los investigadores detrás de OSWorld, el agente quedó atrapado en un bucle entre la página del proyecto y el inicio de sesión del Discord de OSWorld.

Los estándares de OSWorld indican por qué los agentes aún son más una promesa que una realidad. Mientras que los humanos completan el 72 por ciento de las tareas de OSWorld, los agentes fallan en un 38 por ciento en tareas complejas. Sin embargo, cuando se introdujo el estándar en abril de 2024, el mejor agente solo podía completar el 12 por ciento de las tareas. Zhong menciona que la cantidad de datos de entrenamiento disponibles podría limitar el rendimiento de los agentes.

Una posible solución sería incorporar inteligencia humana a la ecuación. Investigando sobre Simular, encontré un proyecto de investigación que demuestra cuán efectivo puede ser combinar habilidades humanas con las de un agente de IA. CowPilot, un plugin para Chrome desarrollado por un equipo de la Universidad Carnegie Mellon, permite la intervención humana si un agente de IA se encuentra atascado. Con CowPilot, el usuario puede hacer clic o escribir si el agente parece dudar.

Jeffrey Bigham, profesor en CMU y supervisor del proyecto desarrollado por su estudiante Faria Huq, menciona que la colaboración entre humanos y agentes “es tan obvia que resulta difícil creer que no sea el enfoque común”. Lo más interesante es que Bigham y Huq destacan que la combinación de un humano y un agente puede realizar más tareas que cada uno por su cuenta. En una prueba limitada, la colaboración logró completar el 95 por ciento de los trabajos asignados, requiriendo intervención humana solo en el 15 por ciento de los pasos totales. “Las páginas web a menudo son difíciles de manejar, especialmente si uno no está familiarizado con un sitio en particular, y a veces el agente puede ayudar a encontrar un buen camino que sería más difícil descubrir solo”, añade Bigham.

La idea de contar con un agente que mejore la productividad y reduzca los errores resulta prometedora.